Comprendre ce qui détermine le passage de la mémorisation à la généralisation constitue aujourd’hui une question centrale au cœur de la recherche mondiale en IA.

Dans un travail récent, Giulio Biroli, Tony Bonnaire et Raphaël Urfin du laboratoire LPENS, en collaboration avec Marc Mézard (Université Bocconi), ont mis en lumière le mécanisme fondamental qui permet aux modèles génératifs d’échapper à la mémorisation et d’acquérir une véritable capacité créative.

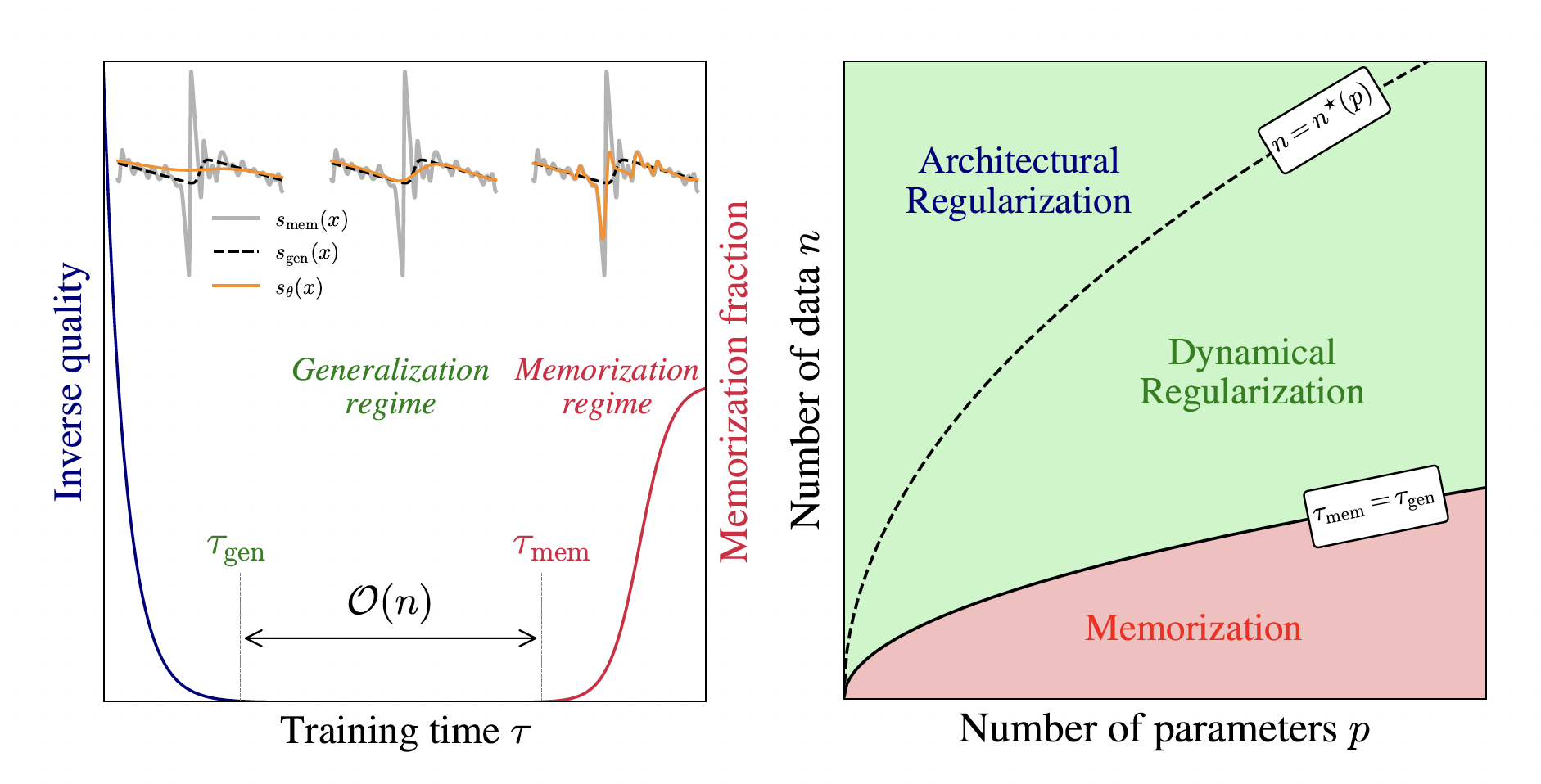

Grâce à une approche combinant physique statistique, informatique et expérimentations numériques, l’équipe a montré que, lorsque l’ensemble de données d’entraînement est très vaste, le processus d’apprentissage commence par une phase de généralisation. Ce n’est qu’après un temps d’entraînement extrêmement long que la mémorisation complète des données devient possible. Autrement dit, plus le nombre de données est grand, plus le temps nécessaire pour mémoriser augmente.

Ces résultats démontrent qu’une IA suffisamment puissante peut, en théorie, finir par mémoriser tous les exemples qui lui sont proposés, mais que dans la plupart des situations réelles, le temps requis devient si important en raison de la taille des ensembles de données que l’IA demeure durablement dans un régime de généralisation — et donc de création véritable.

Ce travail, soumis à NeurIPS 2025 et accepté pour une présentation orale, a reçu le Best Paper Award de NeurIPS 2025.

Il s’agit d’une distinction particulièrement prestigieuse : seuls 4 articles ont été sélectionnés parmi les 21 575 soumis (dont 5 290 acceptés).

Les modèles de diffusion apprennent d’abord à généraliser, puis — seulement après de longues durées d’entraînement, proportionnelles à la taille du jeu de données — finissent par mémoriser. Nous présentons une illustration de ce phénomène dans la figure de gauche, ainsi qu’un diagramme de phase dans celle de droite. Ce dernier montre que le phénomène de régularisation dynamique implicite conduit en pratique à une large plage de paramètres dans laquelle les modèles de diffusion évitent la mémorisation et sont capables de généraliser.

En savoir plus :

– Annonce sur le site de la conférence NeurIPS2025

– L’article

Informations complémentaires :

Laboratoire de physique de L’École normale supérieure (LPENS, ENS Paris/CNRS/Sorbonne Université/Université de Paris)

Auteur correspondant : Giulio Biroli

Contact communication : L’équipe de communication